AI cAt 2024 : implications pour le secteur juridique

Le 31 juillet 2024, l’Union européenne a publié au Journal Officiel le Règlement (UE) 2024/1689 relatif à l’intelligence artificielle, communément appelé « AI Act ». Ce texte constitue le premier cadre réglementaire complet au monde spécifiquement dédié à l’intelligence artificielle. Voici un résumé des principales dispositions et leurs implications pour le secteur juridique.

Contexte et objectifs du règlement

Le règlement s’inscrit dans la stratégie numérique de l’UE et fait suite au livre blanc sur l’IA publié par la Commission européenne en 2020. Il poursuit plusieurs objectifs :

- Garantir que les systèmes d’IA mis sur le marché européen soient sûrs et respectent les droits fondamentaux

- Renforcer la confiance dans le développement et l’adoption de l’IA

- Harmoniser les règles à l’échelle européenne pour éviter la fragmentation du marché intérieur

- Promouvoir une vision européenne de l’IA, centrée sur l’humain et les valeurs démocratiques

Champ d’application

Le règlement s’applique :

- Aux fournisseurs de systèmes d’IA qui les mettent sur le marché ou en service dans l’UE

- Aux utilisateurs de systèmes d’IA situés dans l’UE

- Aux fournisseurs et utilisateurs de systèmes d’IA situés dans des pays tiers lorsque les résultats produits par ces systèmes sont utilisés dans l’UE

Cette portée extraterritoriale, similaire à celle du RGPD, garantit que tous les acteurs respectent les mêmes règles sur le marché européen.

Définition de l’IA

Le règlement définit un système d’IA comme :

« Un système conçu pour fonctionner avec un certain degré d’autonomie et qui, pour des objectifs explicites ou implicites, infère, à partir des données qu’il reçoit, comment générer des résultats tels que des contenus, des prédictions, des recommandations ou des décisions susceptibles d’influencer des environnements physiques ou virtuels. »

Cette définition large et fonctionnelle couvre une vaste gamme de technologies, des algorithmes d’apprentissage automatique aux systèmes experts.

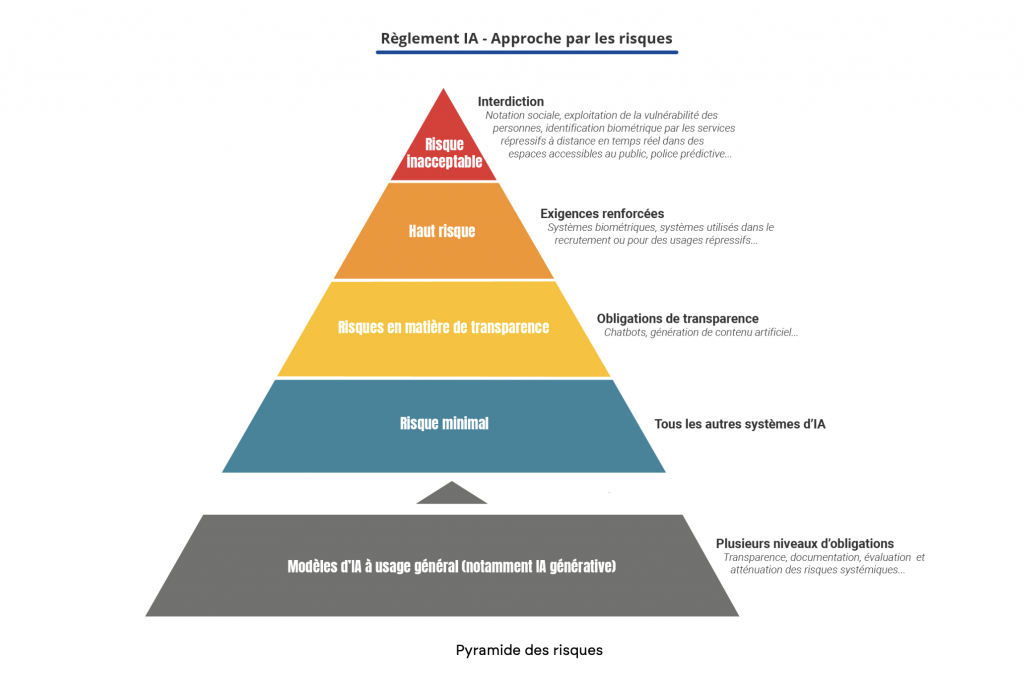

Approche fondée sur les risques

Le règlement adopte une approche fondée sur les risques, classant les systèmes d’IA en quatre catégories :

1. Systèmes à risque inacceptable (interdits)

L’article 5 interdit certaines pratiques d’IA considérées comme présentant un risque inacceptable :

- Systèmes utilisant des techniques subliminales pour manipuler le comportement

- Systèmes exploitant les vulnérabilités de groupes spécifiques (âge, handicap, etc.)

- Systèmes de notation sociale généralisée par les autorités publiques

- Identification biométrique à distance en temps réel dans les espaces publics à des fins répressives (avec exceptions limitées)

2. Systèmes à haut risque

Cette catégorie comprend deux groupes de systèmes :

a) Systèmes d’IA intégrés dans des produits déjà soumis à une législation d’harmonisation :

- Dispositifs médicaux

- Équipements de protection

- Ascenseurs

- Jouets

- Etc.

b) Systèmes d’IA autonomes utilisés dans huit domaines sensibles :

- Identification et catégorisation biométriques

- Gestion des infrastructures critiques

- Éducation et formation professionnelle

- Emploi et gestion des travailleurs

- Accès aux services essentiels et publics

- Application de la loi

- Gestion de la migration et des frontières

- Administration de la justice et processus démocratiques

Cette dernière catégorie comprend notamment les systèmes d’IA assistant les autorités judiciaires dans l’interprétation des faits et du droit ou dans l’application du droit à des faits concrets.

Les systèmes à haut risque doivent satisfaire à des exigences strictes :

- Système de gestion des risques

- Gouvernance des données de qualité

- Documentation technique approfondie

- Conservation des registres d’activité (logging)

- Transparence envers les utilisateurs

- Surveillance humaine effective

- Robustesse, précision et cybersécurité

3. Systèmes à risque limité

Ces systèmes sont soumis à des obligations de transparence :

- Les chatbots doivent informer les utilisateurs qu’ils interagissent avec une IA

- Les deepfakes doivent être clairement étiquetés comme contenu généré ou manipulé

- Les systèmes de reconnaissance des émotions doivent informer les personnes concernées

4. Systèmes à risque minimal

La majorité des applications d’IA actuelles entrent dans cette catégorie et ne sont soumises à aucune obligation spécifique au-delà du cadre juridique existant.

Gouvernance et application

Le règlement établit une structure de gouvernance à plusieurs niveaux :

- Un Comité européen de l’intelligence artificielle

- Des autorités nationales de surveillance

- Des sanctions pouvant atteindre 35 millions d’euros ou 7% du chiffre d’affaires mondial

Implications spécifiques pour le secteur juridique

1. Outils d’IA utilisés par les cabinets d’avocats

Les cabinets d’avocats utilisent de plus en plus d’outils d’IA qui seront soumis à différentes obligations selon leur classification :

- Recherche juridique intelligente : Généralement à risque minimal, sans obligations particulières

- Outils d’analyse prédictive des décisions : Potentiellement classés à haut risque s’ils sont utilisés dans le cadre de l’administration de la justice, nécessitant alors une conformité aux exigences strictes

- Systèmes de rédaction d’actes : Classification variable selon leur impact sur les droits des personnes

- Chatbots juridiques : Soumis aux obligations de transparence (informer qu’il s’agit d’une IA)

2. Obligations de conformité pour les cabinets

Les cabinets d’avocats devront :

- Inventorier les outils d’IA qu’ils utilisent et déterminer leur niveau de risque

- S’assurer que les fournisseurs de ces outils respectent les exigences du règlement

- Pour les outils à haut risque, vérifier l’existence de la documentation technique requise

- Informer les clients de l’utilisation d’outils d’IA dans le traitement de leurs dossiers

- Mettre en place des procédures pour garantir une supervision humaine appropriée

3. Impact sur l’administration de la justice

Le règlement aura un impact significatif sur les systèmes d’IA utilisés dans l’administration de la justice :

- Les systèmes d’aide à la décision judiciaire seront considérés à haut risque

- Les outils d’analyse jurisprudentielle prédictive devront garantir la transparence de leur fonctionnement

- Les systèmes de résolution alternative des litiges assistés par IA devront inclure une supervision humaine

4. Obligations de documentation et traçabilité

Les cabinets utilisant des systèmes à haut risque devront :

- Conserver des traces de l’utilisation de ces systèmes

- Documenter les décisions prises sur la base des résultats fournis par l’IA

- Être en mesure d’expliquer comment ces systèmes ont contribué à l’élaboration des conseils juridiques

Calendrier d’application

Le règlement entrera en vigueur progressivement :

- Été 2024 : Publication au Journal Officiel et entrée en vigueur 20 jours après

- Début 2025 : Application des interdictions (systèmes à risque inacceptable)

- Mi-2025 : Application des obligations de transparence

- Mi-2026 : Application des exigences pour les systèmes à haut risque

- Mi-2027 : Application complète du règlement

Conclusion

L’AI Act représente une étape importante dans la régulation des technologies d’intelligence artificielle, avec des implications significatives pour le secteur juridique. Les avocats et cabinets d’avocats devront non seulement se conformer eux-mêmes à ces nouvelles règles pour leurs propres outils d’IA, mais aussi comprendre comment cette réglementation affecte leurs clients dans divers secteurs.

Cette période transitoire jusqu’à l’application complète en 2027 offre l’opportunité de s’adapter progressivement à ce nouveau cadre réglementaire, qui vise à promouvoir une utilisation de l’IA à la fois innovante et respectueuse des droits fondamentaux.

Référence : Règlement (UE) 2024/1689 du Parlement européen et du Conseil du 13 mars 2024 établissant des règles harmonisées concernant l’intelligence artificielle. Texte intégral disponible sur EUR-Lex